Energie für nachhaltige Rechenzentren

Künstliche Intelligenz (KI) breitet sich rasant aus und durchdringt so viele Aspekte unseres täglichen Lebens, von der Erstellung von Inhalten bis hin zu Online-Chatbots im Kundenservice. Dahinter verbirgt sich eine enorme Zunahme der Datenverarbeitung, die zu einem großen Teil eine leistungsstarke Recheninfrastruktur erfordert. Bevor sie einsatzbereit sind, müssen KI-Modelle trainiert und abgeleitet werden, was normalerweise in modernen Rechenzentren geschieht.

In einem modernen Rechenzentrum befinden sich in der Regel viele Tausende von Hochleistungsservern. Jeder von ihnen benötigt erhebliche Energie, sowohl für den Betrieb als auch für die Kühlung. Mit dem weit verbreiteten schnellen Wachstum steigt der Energieverbrauch im Bereich der KI-Rechenzentren sprunghaft an, was zu Bedenken hinsichtlich der Nachhaltigkeit und der Umweltauswirkungen dieser technologischen Revolution führt.

Die Internationale Energieagentur (IEA) schätzt, dass auf Rechenzentren 1,5% des gesamten Strombedarfs entfallen - etwa 415 Terawattstunden (TWh) im Jahr 2024. Es wird erwartet, dass sich der Verbrauch bis 2030 auf rund 945 TWh mehr als verdoppeln und auf etwa 3% ansteigen wird. Da Rechenzentren häufig in Clustern untergebracht sind, kann es zu einer erheblichen Belastung von Teilen des Stromnetzes kommen.

Die Zukunft gestalten: Anpassung der Stromversorgungsarchitektur von Rechenzentren für KI

Im Vergleich zur typischen Webnutzung, wie z. B. der Suche, ist der Energiebedarf für KI viel höher, oft um das Zehnfache. Dies ist in erster Linie auf die leistungsstarken Grafikprozessoren (GPUs) zurückzuführen, die jeweils Hunderte von Watt verbrauchen können. Trainingsmodelle verbrauchen besonders viel Strom - so werden beispielsweise für das Training von GPT-4 drei Monate lang 25.000 NVIDIA A100-GPUs benötigt, die 50 Gigawattstunden (GWh) Energie verbrauchen und $100 Millionen kosten, so OpenAI.

Die KI ist weit davon entfernt, sich zu verlangsamen, und verdoppelt ihren Stromverbrauch alle sechs Monate, wobei die Branche so viel Energie wie eine kleine Nation verbraucht. Bei dieser Größenordnung sind die Verluste ein echtes Problem. Bei der Übertragung und Verteilung von Strom gehen bis zu 6% Energie durch den Widerstand in den Kabeln verloren. Der Strom vom Netz zur GPU wird mehr als viermal umgewandelt, was zu einem durchschnittlichen Energieverlust von 12% führt.

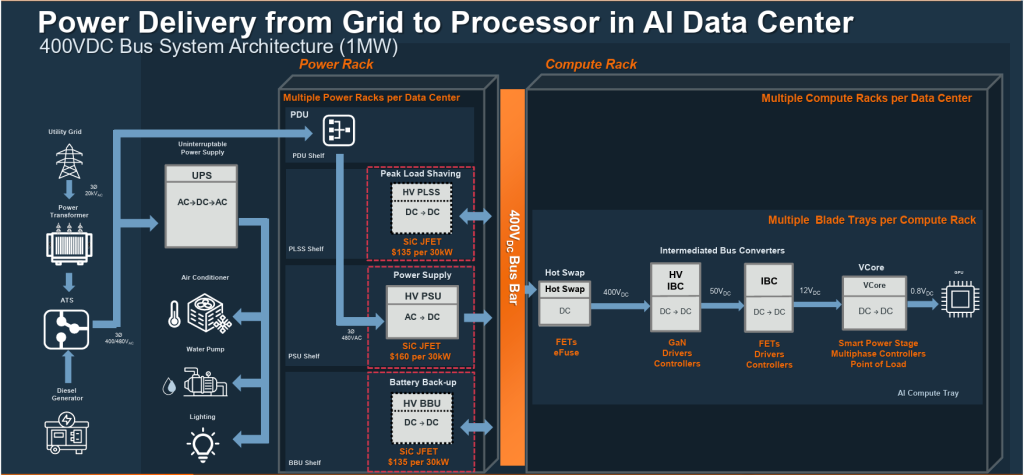

Jeder der Tausenden von Servern kann 40 Kilowatt (kW) verbrauchen, daher wird ein Hochleistungsbus verwendet, um den Strom zu den Racks zu transportieren. Die standardmäßigen 12 Volt Gleichstrom (VDC) hat sich zu einem 48-V-Bus entwickelt.DC um die Ströme zu reduzieren. Um jedoch den Energiebedarf für KI zu decken, ist eine höhere +/-400 VDC Busarchitektur erforderlich sein.

Abbildung 1: Rechenzentren benötigen mehrere Energieumwandlungsstufen

Leistungshalbleiter sind für die effiziente Umwandlung von Energie zur Erfüllung der Anforderungen von KI-Prozessoren und GPUs unerlässlich. Siliziumkarbid (SiC) und Galliumnitrid (GaN) ersetzen Silizium, da sie sehr kompakte und energieeffiziente Leistungswandler ermöglichen und die Gesamtbetriebskosten von Rechenzentren erheblich verbessern.

Innovative Lösungen für Effizienz und Nachhaltigkeit

Die Stromversorgung eines Rechenzentrums vom Netz bis zum GPU-Rack durchläuft viele Energieumwandlungen. Intelligente SiC- und Silizium (Si)-Stromversorgungslösungen sind für jeden Zweig des Stromversorgungsbaums entscheidend. Der Strom durchläuft zunächst einen Solid-State-Transformator (SST) und einen automatischen Umschalter (ATS), der von einem Dieselgenerator unterstützt wird. Die 20k VAC Leitung auf eine dreiphasige 400-V-Leitung umgestellt wirdAC, und geht dann durch eine unterbrechungsfreie Stromversorgung (USV). Die diskreten EliteSiC- und Leistungsmodule können verwendet werden, um eine höhere Effizienz und Leistungsdichte an diesem Eingangspunkt des Rechenzentrums zu erreichen. Die Stromverteilungseinheit wandelt dann die dreiphasigen 400 VAC an eine einphasige 230 VAC Linie auf der Rack-Ebene.

Im Rack, in dem sich die GPU-Server befinden, findet die restliche Stromumwandlung statt. In der Stromversorgungseinheit (PSU) und der Batterie-Backup-Einheit ist die Kombination aus SiC-Kaskoden-JFETs und PowerTrench T10 Si MOSFETs ideal für AC/DC-Lösungen mit hoher Leistung. Die Hochstrom-SiC-Kaskaden-JFETs sind für den Übergang von 3 kW auf 5 kW erforderlich, der in der Hyperscale-Architektur der nächsten Generation erforderlich ist.

EliteSiC 650 V MOSFETs und T10 MOSFETs von onsemi werden bei der Umwandlung von 230 VAC Netzspannung auf 48 VDC zuerst und dann auf 12 VDC entlang des Stromflusses. Die Umwandlungseffizienz ist hier der Schlüssel zur Einhaltung der Open Rack V3 (ORV3) Spezifikation von 97,5% Spitzeneffizienz. Dieser hohe Wirkungsgrad reduziert die Energieverschwendung und trägt zur Senkung der Betriebskosten und des Kühlungsbedarfs bei. Die T10-Si-MOSFETs und Power-Management-ICs werden auch für die Umwandlung der 48 V in eine IBC-Spannung (Intermediate Bus Converter) von 12 V verwendet, um den Vcore-Zweig (CPU-Kernspannung) des Leistungsbaums zu versorgen. Darüber hinaus bieten SiC-JFETs und SiC-Combo-JFETs für 400/800-V-Bus-Architekturen einen zuverlässigen Überstromschutz für Hot Swap/E-Fuse vor der IBC-Stufe.

Die Zukunft des Energiemanagements in KI-Rechenzentren

Effizienz ist der wichtigste Energieparameter in KI-Rechenzentren. Das bedeutet, dass Verluste so weit wie möglich minimiert werden müssen, nicht zuletzt, weil die Kühlung bis zu 50% des in Rechenzentren verbrauchten Stroms verbrauchen kann, während die andere Hälfte von der IT-Ausrüstung wie Servern, Speichersystemen und der Strominfrastruktur verbraucht wird.

onsemi ist führend bei Lösungen für KI-Rechenzentren und einer der wenigen Anbieter, die die Anforderungen des gesamten Energiebaums vom Netz bis zur GPU erfüllen können. Die Zukunft erfordert fortschrittliche Technologien mit breiter Bandlücke, wie EliteSiC und vertikales GaN von onsemi, für ihre robuste Leistungsumwandlung bei höheren Frequenzen und höheren Wirkungsgraden, die kompaktere Designs ermöglichen. Diese Geräte können bei höheren Temperaturen zuverlässig arbeiten, erfordern weniger Kühlung und ermöglichen kompaktere Lösungen sowie eine Senkung der Betriebskosten.